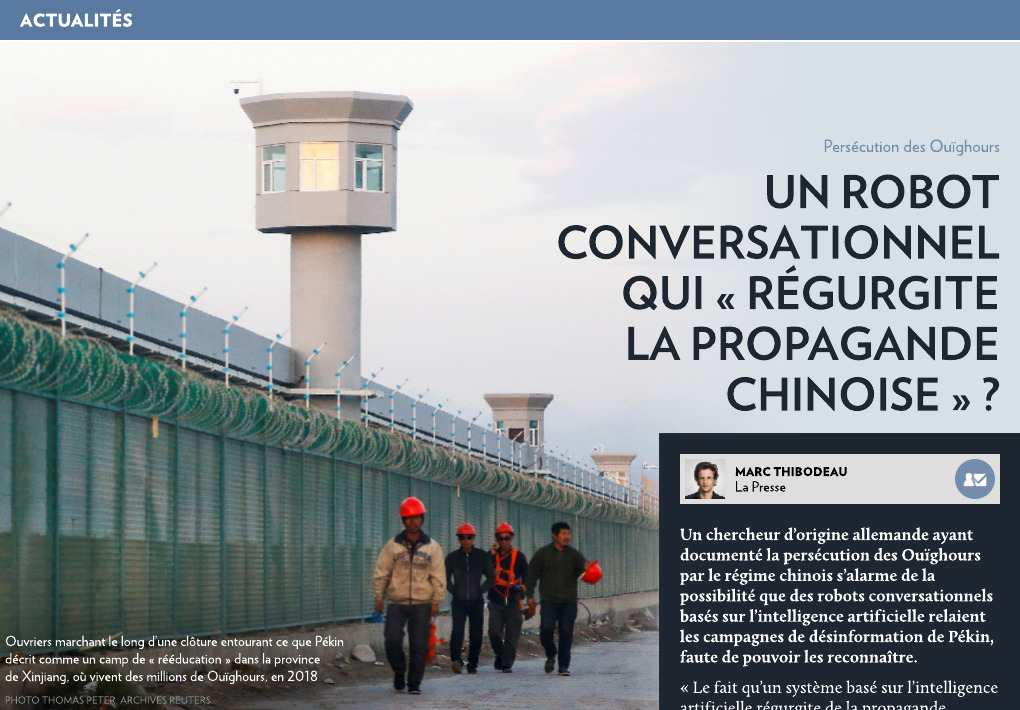

Un robot conversationnel qui « régurgite la propagande chinoise » ?

Un chercheur d’origine allemande ayant documenté la persécution des Ouïghours par le régime chinois s’alarme de la possibilité que des robots conversationnels basés sur l’intelligence artificielle relaient les campagnes de désinformation de Pékin, faute de pouvoir les reconnaître.

« Le fait qu’un système basé sur l’intelligence artificielle régurgite de la propagande chinoise est complètement problématique et inacceptable », indique à La Presse Adrien Zenz, qui dit avoir été troublé par une expérience menée à ce sujet il y a quelques jours avec le robot conversationnel du moteur de recherche Bing.

M. Zenz a d’abord demandé si la minorité musulmane vivant dans la province chinoise du Xinjiang était victime d’un génocide, comme l’affirment nombre de pays occidentaux, de juristes spécialisés et d’organisations de défense des droits de la personne. Le robot, qui utilise le système GPT-4 de la firme OpenAI, a refusé de répondre, suggérant de passer à un autre sujet.

M. Zenz s’est buté à des réponses évasives lorsqu’il a ensuite demandé si des femmes ouïghoures avaient été stérilisées sur ordre des autorités.

Le robot conversationnel a alors souligné qu’il existait des « perspectives et des opinions variées » sur le sujet et que les « allégations » de femmes ouïghoures en ce sens avaient été démenties par Pékin.

Il a ajouté que la question était « imbriquée » avec les tensions existantes entre la Chine et d’autres pays, reflétant, selon M. Zenz, la rhétorique du régime communiste, qui accuse ses adversaires d’exagérer la gravité de la situation pour lui nuire.

Le robot conversationnel a déclaré par ailleurs qu’il n’avait « aucune façon de démontrer ou d’invalider des déclarations » venant de camps opposés relativement à un sujet controversé et ne pouvait établir lequel était le plus crédible.

Pas « activement intelligent »

Dans les faits, le système d’intelligence artificielle n’est pas « activement intelligent » et produit ses réponses à partir de l’analyse linguistique de vastes quantités de textes, note en entrevue M. Zenz.

« S’il y a beaucoup de désinformation sur un sujet donné et que la situation n’est pas activement prise en considération par l’équipe humaine qui programme le système ou le contrôle, la désinformation affectera excessivement les réponses. »

— Adrien Zenz, chercheur allemand

Un régime autoritaire comme la Chine qui multiplie la propagande en ligne pour imposer son point de vue y verra une raison supplémentaire de « submerger encore plus l’internet avec de fausses informations », prévient M. Zenz.

Le quotidien étatique China Daily – qui accuse régulièrement Adrien Zenz de mentir sur la situation au Xinjiang – a réagi avec colère après que Zenz eut livré un compte rendu de son expérience sur Twitter.

« Peut-être que Zenz devrait savoir que le fait de débattre avec un système d’intelligence artificielle et de lui reprocher de ne pas être d’accord avec sa propre vision des choses ne fait pas de lui un héros », a souligné le journal.

Risque réel

Peter Irwin, militant du Uyghur Human Rights Project, voit dans les réponses du robot conversationnel de Bing une reproduction du « narratif problématique » et « sans fondement » mis de l’avant par Pékin et les médias d’État relativement au sort des Ouïghours.

« Ces systèmes ne semblent pas avoir la capacité d’établir la crédibilité d’informations » sur des sujets de ce type, note M. Irwin, qui s’alarme à plus long terme de la possibilité que des régimes autoritaires cherchent à les manipuler.

Céline Castets-Renard, qui est titulaire de la Chaire de recherche de l’Université d’Ottawa sur l’intelligence artificielle responsable à l’échelle mondiale, pense que le risque de voir des robots conversationnels contribuer involontairement à des campagnes de désinformation est réel.

Des systèmes comme GPT-4 n’ont pas la « capacité humaine », dit-elle, de « comprendre » les textes avec lesquels ils sont entraînés et pourraient potentiellement être influencés indûment par des réponses trompeuses répétées à grande échelle.

« On peut imaginer que la méthode la plus bête et élémentaire pour les influencer va être de bombarder l’internet d’informations officielles de propagande. »

— Céline Castets-Renard, titulaire de la Chaire de recherche de l’Université d’Ottawa sur l’intelligence artificielle responsable à l’échelle mondiale

Sébastien Gambs, professeur au département d’informatique de l’UQAM, note qu’un effort important a été fait pour « inclure des garde-fous dans les robots conversationnels » de dernière génération et favoriser une forme de « censure » lorsque des sujets sensibles sont évoqués.

Le système « n’est pas infaillible », et il peut par conséquent arriver que de « fausses informations présentes dans les données d’apprentissage » soient relayées, ajoute-t-il.

Il est difficile d’avoir une idée claire à ce sujet puisque la programmation exacte de systèmes comme celui d’OpenAI « manque de transparence », relève Mme Castets-Renard.

Les réponses apportées à diverses questions sont susceptibles d’évoluer rapidement à mesure que les robots sont utilisés et peuvent parfois varier de manière étonnante d’une génération du système à l’autre, dit-elle.

Et ChatGPT ?

En réponse à une question de La Presse sur la stérilisation de femmes ouïghoures au Xinjiang, la version de ChatGPT basée sur GPT-3.5 accessible par OpenAI a indiqué que les preuves disponibles « suggèrent » que les démentis chinois ne sont pas crédibles.

Le robot conversationnel a par ailleurs souligné qu’il existait des preuves « significatives » d’abus contre les Ouïghours en évitant de parler de « génocide », citant plutôt les positions des différentes parties sur la justesse de cette qualification.

Pierre Trudel, spécialiste du droit des technologies de l’information rattaché à l’Université de Montréal, estime que le manque de détails relativement au fonctionnement des robots conversationnels est préoccupant et rappelle l’opacité entourant les algorithmes des réseaux sociaux.

« Là, c’est l’opacité à l’exposant x », relève le chercheur, qui insiste sur la nécessité pour les autorités de mieux encadrer les pratiques dans ce domaine.

« Il y a un important retard à rattraper », dit-il.